为了推动AI与教学研究的深度融合,推动智能时代下卓越育人模式转型升级,2024年7月25日,经济与管理学院信息资源管理学科前沿讲座“大数据分析进级之路一从神经网络到大语言模型”在线上举行。本次讲座由华东师范大学经济与管理学院信息管理系副教授王仁武主讲,由信息管理系系主任蔚海燕副教授主持,参加此次讲座的主要为信息资源管理学科50多名教师、博士和硕士研究生。

讲座开场

此次讲座中,王仁武老师主要对神经网络、卷积与循环处理、序列到序列模型、Transformer统一架构、大语言模型概要、以及研究和应用案例等内容进行讲解,循序渐进地带领老师和同学了解从神经网络到大语言模型的发展轨迹。

讲座主要内容

首先,王老师通过历史渊源、核心概念、权重与反向传播来简单介绍神经网络。对于卷积神经网络,主要介绍了其原理以及局部连接、权值共享、池化采样这三个要素,也介绍了卷积神经网络的相关代码以及研究案例。对于循环神经网络,强调了其拥有记忆功能,但也指出循环神经网络会伴有梯度消失或者梯度爆炸等问题,这些不足也是为了引入了LSTM、GRU。

然后,为了解决循环神经网络在特定任务能力上的不足,难以解决输入与输出序列具有不同大小与类型的问题,引入序列到序列模型。强调了序列到序列模型考虑了输出的标签之间的序列依赖性这一优点后,又介绍了注意力机制以及自注意力机制。自注意力机制的介绍也为Transformer统一架构的介绍进行了铺垫。

Transformer模型完全基于自注意力机制,没有任何卷积层或循环神经网络层,且广泛应用于语言、视觉、语音和强化学习等各领域。在Transformer模型这一部分,王老师还解释了BERT以及GPT的原理。从神经网络探秘到Transformer统一架构,王老师以严谨的学术态度以及清晰的阐述向同学们介绍了神经网络的进化道路,也为同学们后续学习大语言模型的内容打下夯实的基础。

在大语言模型部分,除了基本概念、弱人工智能、中人工智能以及强人工智能的介绍,王老师还阐释了GPT发展历程、全球大语言模型进化史、开源与闭源大模型比较、涌现能力、提示学习、采用DiT架构的Sora、AIGC产业图谱、机遇与挑战、安全与对齐技术等内容。

讲座尾声

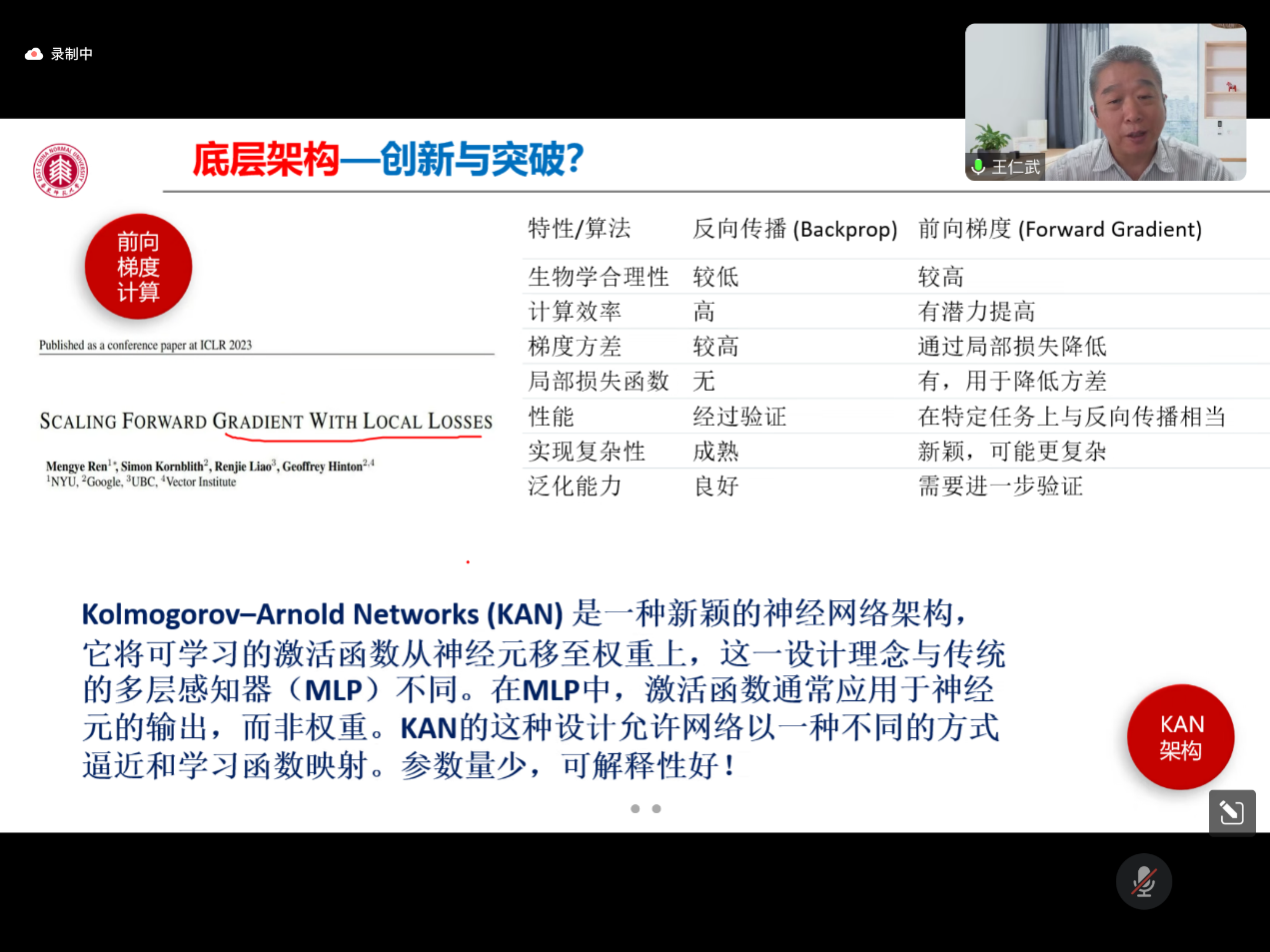

讲座最后,王老师还简述了一些新的神经网络技术如KAN。随后,王老师为本次讲座进行总结,并且热情地和同学互动。此次以“大数据分析进级之路一从神经网络到大语言模型”为主题的前沿讲座在师生的赞誉声中圆满结束!

编辑|郁思雨

编审|肖启玉